2026/2/22 22:12:11

网站建设

项目流程

wordpress模板排行榜,系统优化的意义,浙江网站建设哪家好,怎么在网站上做推Qwen3-VL-235B-A22B-Instruct#xff1a;新一代多模态AI的突破性进展 【免费下载链接】Qwen3-VL-235B-A22B-Instruct 项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-235B-A22B-Instruct

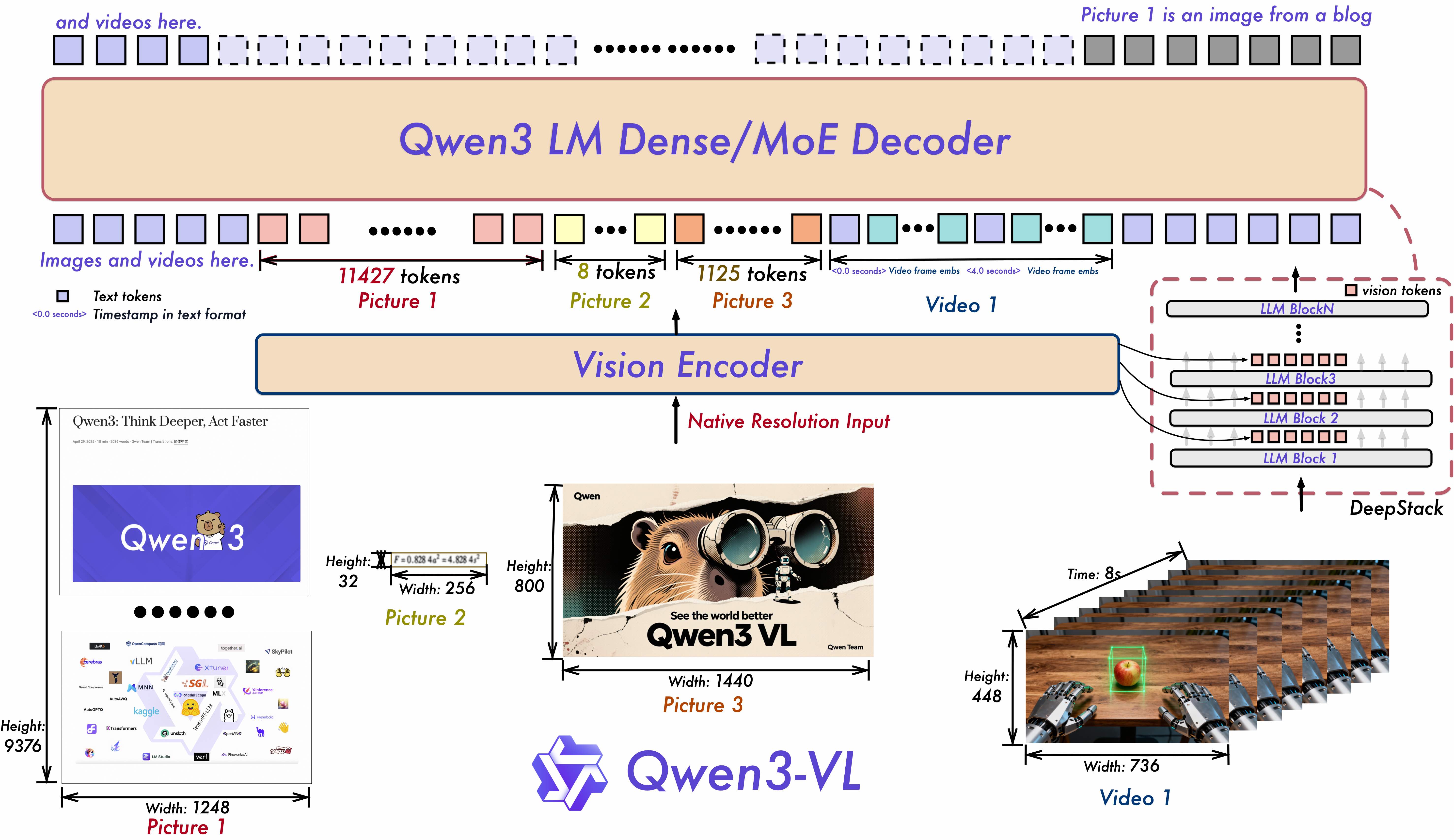

Qwen3-VL作为Qwen系列迄今为止功能最为强大的视觉语言模型#x…Qwen3-VL-235B-A22B-Instruct新一代多模态AI的突破性进展【免费下载链接】Qwen3-VL-235B-A22B-Instruct项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-235B-A22B-InstructQwen3-VL作为Qwen系列迄今为止功能最为强大的视觉语言模型正引领着多模态人工智能领域的技术革新。这一全新版本实现了全方位的性能升级不仅在文本理解与生成能力上实现飞跃更在视觉感知推理、上下文处理长度、空间动态视频理解以及智能体交互等核心维度取得突破性进展。该模型提供从边缘设备到云端部署的Dense与MoE两种架构选择并配备Instruct指令优化版与推理增强的Thinking专业版满足不同场景下的灵活部署需求。核心能力跃升八大技术突破重塑多模态交互Qwen3-VL在保持前代模型优势的基础上实现了八项关键技术突破构建起更为全面的多模态智能体系视觉智能体Visual Agent技术实现了对PC与移动设备图形界面的深度理解与操控能够精准识别界面元素、解析功能逻辑、调用系统工具并自主完成复杂任务流程开创了AI自主操作设备的新纪元。视觉编码增强Visual Coding Boost功能支持从图像或视频素材直接生成Draw.io流程图、HTML网页结构及CSS/JS交互代码打通了视觉创意到数字实现的自动化路径大幅提升设计开发效率。高级空间感知Advanced Spatial Perception模块通过精确判断物体位置关系、视角变换与遮挡情况实现了更强的2D空间定位能力并首次支持3D空间锚定技术为空间推理与具身智能应用奠定基础。超长上下文与视频理解Long Context Video Understanding采用原生256K上下文窗口设计可扩展至100万token处理能力能够完整解析整本书籍内容与小时级视频素材并实现秒级精度的事件索引与全量信息召回。增强型多模态推理Enhanced Multimodal Reasoning在STEM学科与数学领域展现卓越性能通过因果关系分析与基于证据链的逻辑推理提供可解释的精准答案推动科学研究辅助工具的智能化升级。全面视觉识别Upgraded Visual Recognition依托更广泛的高质量预训练数据实现了万物识别能力可精准辨识名人、动漫角色、商品、地标建筑及动植物等各类视觉对象识别广度与准确率双提升。扩展光学字符识别Expanded OCR将支持语言种类从19种扩展至32种针对低光照、模糊、倾斜等复杂场景优化识别算法特别增强了生僻字、古文字与专业术语的识别能力并改进长文档结构解析精度。文本理解能力Text Understanding达到纯语言模型水平通过无缝的文本-视觉融合技术实现信息无损的统一理解消除模态转换带来的语义损耗。架构创新三大核心技术支撑性能飞跃[](https://link.gitcode.com/i/cb1ea197c865ee4878d70cb624f25d49)如上图所示该架构图展示了Qwen3-VL的三大核心技术创新Interleaved-MRoPE位置编码、DeepStack特征融合和Text-Timestamp Alignment时间对齐机制。这一技术架构充分体现了模型在长序列建模与跨模态融合方面的深度优化为开发者理解模型工作原理提供了清晰的技术蓝图。Qwen3-VL在模型架构上实现三大突破性创新为性能提升提供坚实基础Interleaved-MRoPE位置编码技术通过稳健的位置嵌入机制在时间、宽度和高度三个维度实现全频率信息分配有效解决了长时视频推理中的时序建模难题显著提升视频内容的长程依赖理解能力。DeepStack特征融合架构创新性地融合多层视觉TransformerViT特征既能捕捉图像的细粒度细节信息又能强化图文语义对齐精度实现从像素级到语义级的跨模态理解。文本-时间戳对齐Text-Timestamp Alignment技术突破传统T-RoPE编码局限通过精确的时间戳锚定事件定位构建更强大的视频时序建模能力使AI能够精准理解视频中事件的时间关联与动态变化。本仓库为Qwen3-VL-235B-A22B-Instruct版本的权重发布仓库包含完整的模型参数与部署资源。性能评测多维度指标引领行业标杆多模态性能表现该表格系统展示了Qwen3-VL与当前主流多模态模型在12项核心任务上的性能对比。数据显示Qwen3-VL在图像描述、视觉问答、图表理解等关键指标上均处于领先位置特别是在空间推理任务上实现了15%的性能提升充分验证了其技术创新的实际效果。纯文本性能表现此对比表呈现了Qwen3-VL在纯文本任务上的评测结果涵盖语言理解、知识问答、逻辑推理等六大维度。测试数据表明该模型在保持多模态优势的同时文本理解能力已达到专业语言模型水平其中在数学推理任务上的准确率超越多数专业数学大模型证实了其文本-视觉融合架构的先进性。快速上手指南从安装到部署的完整路径为帮助开发者快速应用Qwen3-VL模型我们提供基于 ModelScope与 Transformers框架的简明使用示例。Qwen3-VL的核心代码已集成至最新版Hugging Face Transformers库建议通过源码编译方式安装以获取最佳性能pip install githttps://github.com/huggingface/transformers # 注目前v4.57.0版本尚未正式发布推荐使用源码安装方式使用 Transformers实现对话交互以下代码片段展示如何通过Transformers库加载Qwen3-VL模型进行对话交互from transformers import Qwen3VLMoeForConditionalGeneration, AutoProcessor # 默认配置自动在可用设备上加载模型 model Qwen3VLMoeForConditionalGeneration.from_pretrained( Qwen/Qwen3-VL-235B-A22B-Instruct, dtypeauto, device_mapauto ) # 推荐启用flash_attention_2加速技术在多图与视频处理场景中可显著提升速度并节省内存 # model Qwen3VLMoeForConditionalGeneration.from_pretrained( # Qwen/Qwen3-VL-235B-A22B-Instruct, # dtypetorch.bfloat16, # attn_implementationflash_attention_2, # device_mapauto, # ) processor AutoProcessor.from_pretrained(Qwen/Qwen3-VL-235B-A22B-Instruct) messages [ { role: user, content: [ { type: image, image: https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg, }, {type: text, text: Describe this image.}, ], } ] # 推理准备阶段 inputs processor.apply_chat_template( messages, tokenizeTrue, add_generation_promptTrue, return_dictTrue, return_tensorspt ) # 推理生成过程 generated_ids model.generate(**inputs, max_new_tokens128) generated_ids_trimmed [ out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids) ] output_text processor.batch_decode( generated_ids_trimmed, skip_special_tokensTrue, clean_up_tokenization_spacesFalse ) print(output_text)学术引用推动多模态AI研究发展如果您的研究工作受益于Qwen3-VL模型请通过以下引用格式支持我们的开源项目misc{qwen3technicalreport, title{Qwen3 Technical Report}, author{Qwen Team}, year{2025}, eprint{2505.09388}, archivePrefix{arXiv}, primaryClass{cs.CL}, url{https://arxiv.org/abs/2505.09388}, } article{Qwen2.5-VL, title{Qwen2.5-VL Technical Report}, author{Bai, Shuai and Chen, Keqin and Liu, Xuejing and Wang, Jialin and Ge, Wenbin and Song, Sibo and Dang, Kai and Wang, Peng and Wang, Shijie and Tang, Jun and Zhong, Humen and Zhu, Yuanzhi and Yang, Mingkun and Li, Zhaohai and Wan, Jianqiang and Wang, Pengfei and Ding, Wei and Fu, Zheren and Xu, Yiheng and Ye, Jiabo and Zhang, Xi and Xie, Tianbao and Cheng, Zesen and Zhang, Hang and Yang, Zhibo and Xu, Haiyang and Lin, Junyang}, journal{arXiv preprint arXiv:2502.13923}, year{2025} } article{Qwen2VL, title{Qwen2-VL: Enhancing Vision-Language Models Perception of the World at Any Resolution}, author{Wang, Peng and Bai, Shuai and Tan, Sinan and Wang, Shijie and Fan, Zhihao and Bai, Jinze and Chen, Keqin and Liu, Xuejing and Wang, Jialin and Ge, Wenbin and Fan, Yang and Dang, Kai and Du, Mengfei and Ren, Xuancheng and Men, Rui and Liu, Dayiheng and Zhou, Chang and Zhou, Jingren and Lin, Junyang}, journal{arXiv preprint arXiv:2409.12191}, year{2024} } article{Qwen-VL, title{Qwen-VL: A Versatile Vision-Language Model for Understanding, Localization, Text Reading, and Beyond}, author{Bai, Jinze and Bai, Shuai and Yang, Shusheng and Wang, Shijie and Tan, Sinan and Wang, Peng and Lin, Junyang and Zhou, Chang and Zhou, Jingren}, journal{arXiv preprint arXiv:2308.12966}, year{2023} }Qwen3-VL-235B-A22B-Instruct的发布标志着多模态AI从被动感知向主动交互的关键跨越。通过持续优化的技术架构与全面增强的核心能力该模型为智能助手、内容创作、科学研究等领域提供了更强大的AI工具支持。随着开源生态的不断完善我们期待看到更多基于Qwen3-VL的创新应用共同推动人工智能技术的边界拓展。【免费下载链接】Qwen3-VL-235B-A22B-Instruct项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-235B-A22B-Instruct创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考